Google Cloud ने एक ब्लॉग पोस्ट प्रकाशित की है जिसमें डेवलपर्स के सामने AI मॉडल को होस्ट करने के लिए इन्फ्रास्ट्रक्चर चुनते समय आने वाले विकल्पों पर चर्चा की गई है, खासकर बड़े भाषा मॉडल (LLM) पर ध्यान केंद्रित करते हुए। लेख में Google Kubernetes Engine (GKE) जैसे स्व-प्रबंधित समाधानों और Vertex AI जैसे पूरी तरह से प्रबंधित समाधानों के सापेक्ष गुणों और कमियों पर प्रकाश डाला गया है।

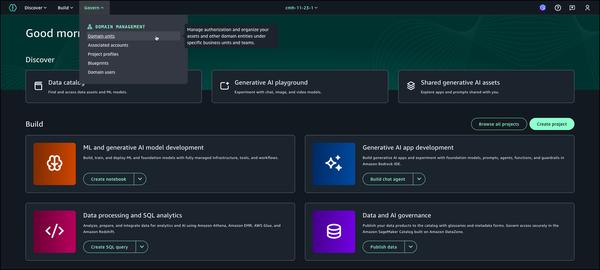

लेख में एक दिलचस्प पहलू पर ज़ोर दिया गया है कि LLM इन्फ्रास्ट्रक्चर पर निर्णय लेते समय प्रोजेक्ट की ज़रूरतों और आवश्यकताओं को समझना महत्वपूर्ण है। उपयोग में आसानी और कार्यान्वयन की गति को प्राथमिकता देने वाली टीमों के लिए, Vertex AI स्वचालित स्केलिंग और सुरक्षा अपडेट जैसी प्रबंधित सुविधाओं के साथ एक सम्मोहक समाधान प्रस्तुत करता है। दूसरी ओर, GKE मज़बूत DevOps टीमों और विशिष्ट आवश्यकताओं वाले संगठनों के लिए अधिक नियंत्रण, अनुकूलन और संभावित लागत बचत प्रदान करता है।

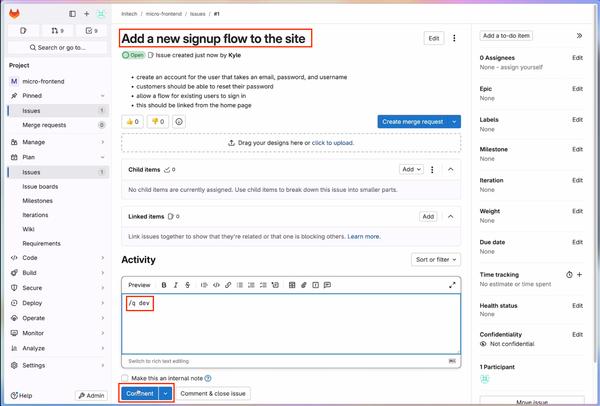

लेख कुशल LLM अनुमान के लिए Cloud Run पर तैनात एक जावा एप्लिकेशन का व्यावहारिक उदाहरण भी प्रदान करता है। यह उदाहरण दिखाता है कि कैसे संगठन तैनाती को सरल बनाने और मापनीयता प्राप्त करने के लिए Cloud Run के सर्वर रहित इन्फ्रास्ट्रक्चर का लाभ उठा सकते हैं। इसके अलावा, लेख vLLM का उपयोग करके GKE पर एक ओपन-सोर्स मॉडल को तैनात करने के चरणों में तल्लीन करता है, जो अपने स्वयं के मॉडल को होस्ट करने की चाहत रखने वाले संगठनों के लिए एक व्यापक मार्गदर्शिका प्रदान करता है।

कुल मिलाकर, लेख LLM इन्फ्रास्ट्रक्चर चुनने में शामिल विचारों का एक व्यावहारिक विश्लेषण प्रस्तुत करता है। Vertex AI और GKE दोनों के पेशेवरों और विपक्षों पर प्रकाश डालकर, लेख डेवलपर्स, DevOps इंजीनियरों और IT निर्णय निर्माताओं को उनकी विशिष्ट आवश्यकताओं के अनुरूप सूचित निर्णय लेने के लिए ज्ञान से लैस करता है। लेख में दर्शाए गए अनुसार, उपयोग में आसानी और अनुकूलन के बीच संतुलन सफल LLM परिनियोजन और जेनेरेटिव AI की शक्ति का उपयोग करने के लिए महत्वपूर्ण है।