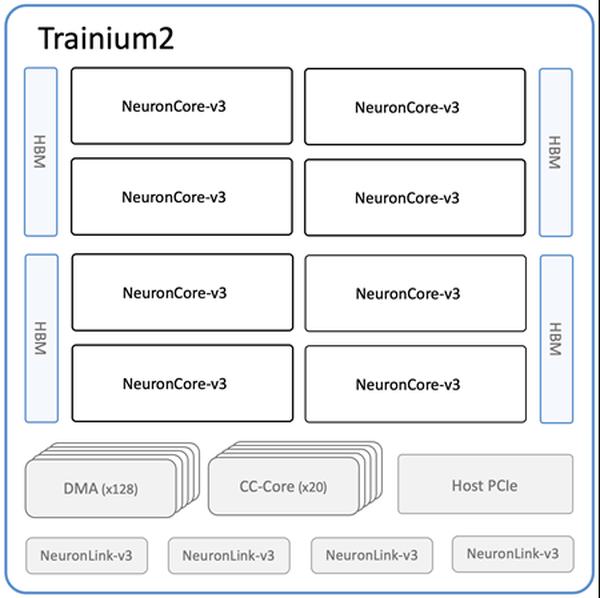

Amazon ने नई Amazon EC2 Trn2 इंस्टेंस और Trn2 UltraServers की उपलब्धता की घोषणा की है, जो ML प्रशिक्षण और अनुमान के लिए इसके सबसे शक्तिशाली EC2 कंप्यूट विकल्प हैं। AWS Trainium चिप्स (AWS Trainium2) की दूसरी पीढ़ी द्वारा संचालित, Trn2 इंस्टेंस पहली पीढ़ी के Trn1 इंस्टेंस की तुलना में 4 गुना तेज़ हैं, इनमें 4 गुना अधिक मेमोरी बैंडविड्थ और 3 गुना अधिक मेमोरी क्षमता है। ये वर्तमान पीढ़ी के GPU-आधारित EC2 P5e और P5en इंस्टेंस की तुलना में 30-40% बेहतर मूल्य प्रदर्शन प्रदान करते हैं। प्रत्येक Trn2 इंस्टेंस में 16 Trainium2 चिप्स, 192 vCPU, 2 TiB मेमोरी और 3.2 Tbps इलास्टिक फैब्रिक एडॉप्टर (EFA) v3 नेटवर्क बैंडविड्थ है जिसमें 50% तक कम विलंबता है। एक नई पेशकश, Trn2 UltraServers, में फ्रंटियर फाउंडेशन मॉडल पर चरम प्रदर्शन के लिए उच्च-बैंडविड्थ, कम-विलंबता वाले NeuronLink इंटरकनेक्ट से जुड़े 64 Trainium2 चिप्स हैं। हज़ारों Trainium चिप्स पहले से ही Amazon और AWS सेवाओं को शक्ति प्रदान कर रहे हैं। 80,000 से अधिक AWS Inferentia और Trainium1 चिप्स ने प्राइम डे पर Rufus शॉपिंग असिस्टेंट का समर्थन किया। Trainium2 चिप्स Amazon Bedrock पर Llama 3.1 405B और Claude 3.5 Haiku मॉडल के विलंबता-अनुकूलित संस्करणों को शक्ति प्रदान करते हैं। Trn2 इंस्टेंस यूएस ईस्ट (ओहियो) क्षेत्र में उपलब्ध हैं और इन्हें ML के लिए Amazon EC2 क्षमता ब्लॉक का उपयोग करके आरक्षित किया जा सकता है। डेवलपर्स PyTorch और JAX जैसे फ्रेमवर्क के साथ पूर्व-कॉन्फ़िगर किए गए AWS डीप लर्निंग AMI का उपयोग कर सकते हैं। मौजूदा AWS Neuron SDK ऐप्स को Trn2 के लिए पुन: संकलित किया जा सकता है। SDK, JAX, PyTorch और Hugging Face, PyTorch Lightning, और NeMo जैसी लाइब्रेरी के साथ एकीकृत होता है। Neuron में NxD प्रशिक्षण और NxD अनुमान के साथ वितरित प्रशिक्षण और अनुमान के लिए अनुकूलन शामिल हैं, और OpenXLA का समर्थन करता है, जिससे PyTorch/XLA और JAX डेवलपर्स Neuron के कंपाइलर अनुकूलन का लाभ उठा सकते हैं।

AI/ML प्रशिक्षण और अनुमान के लिए Amazon EC2 Trn2 इंस्टेंस और Trn2 UltraServers अब उपलब्ध हैं

AWS