Meta ने Llama 3.2 मॉडल जारी किए हैं, जो बेहतर क्षमताओं, व्यापक प्रयोज्यता और मल्टीमॉडल इमेज सपोर्ट के साथ भाषा मॉडल की एक अभूतपूर्व श्रृंखला है, जो अब Amazon Bedrock में उपलब्ध है। यह रिलीज़ बड़े भाषा मॉडल (LLM) में एक महत्वपूर्ण प्रगति का प्रतिनिधित्व करता है, जो विभिन्न उपयोग के मामलों में बेहतर क्षमताओं और व्यापक प्रयोज्यता प्रदान करता है।

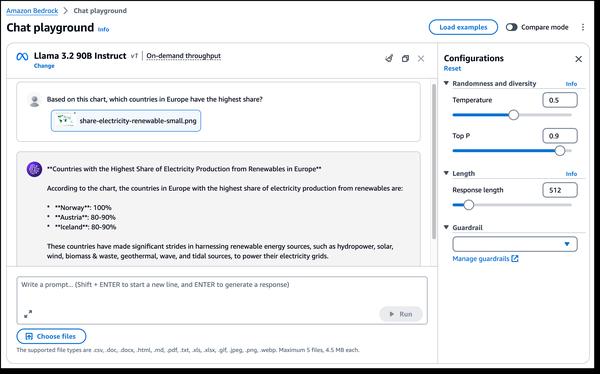

Llama 3.2 के सबसे रोमांचक पहलुओं में से एक मल्टीमॉडल विजन क्षमताओं का परिचय है। नए 90B और 11B मॉडल इमेज समझ और विजुअल रीजनिंग के लिए डिज़ाइन किए गए हैं, जो इमेज कैप्शनिंग, इमेज-टेक्स्ट रिट्रीवल और विजुअल प्रश्न उत्तर जैसे अनुप्रयोगों के लिए नई संभावनाएं खोलते हैं। ये क्षमताएं विभिन्न डोमेन में हम जिस तरह से इमेज के साथ इंटरैक्ट करते हैं और उनका उपयोग करते हैं, उसमें क्रांति ला सकती हैं।

इसके अतिरिक्त, Llama 3.2 एज डिवाइस के लिए उपयुक्त लाइटवेट मॉडल प्रदान करता है। 1B और 3B मॉडल कम विलंबता और बेहतर प्रदर्शन के साथ संसाधन-कुशल होने के लिए डिज़ाइन किए गए हैं, जो उन्हें सीमित क्षमताओं वाले उपकरणों पर अनुप्रयोगों के लिए आदर्श बनाते हैं। इससे मोबाइल उपकरणों पर अधिक बुद्धिमान AI- संचालित लेखन सहायक और ग्राहक सेवा अनुप्रयोगों का विकास हो सकता है।

इसके अलावा, Llama 3.2, Llama Stack के शीर्ष पर बनाया गया है, जो कैनोनिकल टूलचेन घटकों और एजेंटिक अनुप्रयोगों के निर्माण के लिए एक मानकीकृत इंटरफ़ेस है, जो निर्माण और परिनियोजन को पहले से कहीं अधिक आसान बनाता है। यह डेवलपर्स को अपने अनुप्रयोगों में Llama मॉडल को एकीकृत करने का एक मानकीकृत और कुशल तरीका प्रदान करता है।

कुल मिलाकर, Llama 3.2 की रिलीज़ बड़े भाषा मॉडल के क्षेत्र में एक महत्वपूर्ण कदम है। इसकी बेहतर क्षमताएं और व्यापक प्रयोज्यता इमेज समझ और विजुअल रीजनिंग से लेकर एज अनुप्रयोगों तक, उपयोग के मामलों की एक विस्तृत श्रृंखला के लिए नई संभावनाएं खोलती हैं। जैसे-जैसे जेनरेटिव AI तकनीक का विकास जारी है, हम Llama 3.2 जैसे मॉडल से और अधिक नवाचारों और परिवर्तनकारी अनुप्रयोगों की उम्मीद कर सकते हैं।