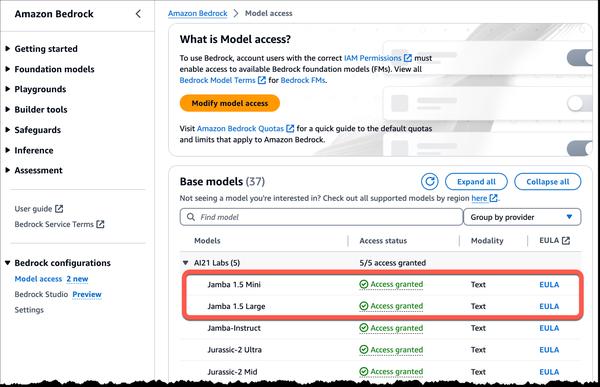

AWS और AI21 Labs ने Amazon Bedrock में AI21 Labs के शक्तिशाली नए Jamba 1.5 परिवार के बड़े भाषा मॉडल (LLM) की उपलब्धता की घोषणा की है। ये मॉडल लंबे-संदर्भ वाली भाषा क्षमताओं में एक महत्वपूर्ण प्रगति का प्रतिनिधित्व करते हैं, जो अनुप्रयोगों की एक विस्तृत श्रृंखला में गति, दक्षता और प्रदर्शन प्रदान करते हैं।

Jamba 1.5 मॉडल एक अद्वितीय हाइब्रिड आर्किटेक्चर का लाभ उठाते हैं जो ट्रांसफॉर्मर मॉडल आर्किटेक्चर को स्ट्रक्चर्ड स्टेट स्पेस मॉडल (SSM) तकनीक के साथ जोड़ता है। यह अभिनव दृष्टिकोण Jamba 1.5 मॉडलों को पारंपरिक ट्रांसफॉर्मर मॉडलों की उच्च-प्रदर्शन विशेषताओं को बनाए रखते हुए 256K टोकन तक के लंबे संदर्भ विंडो को संभालने की अनुमति देता है।

Jamba 1.5 मॉडलों की कुछ प्रमुख खूबियाँ इस प्रकार हैं:

* लंबे संदर्भ प्रबंधन: 256K टोकन संदर्भ लंबाई के साथ, Jamba 1.5 मॉडल एंटरप्राइज़ अनुप्रयोगों की गुणवत्ता में सुधार कर सकते हैं, जैसे कि लंबे दस्तावेज़ सारांश और विश्लेषण, साथ ही एजेंटिक और RAG वर्कफ़्लो।

* बहुभाषी: अंग्रेजी, स्पेनिश, फ्रेंच, पुर्तगाली, इतालवी, डच, जर्मन, अरबी और हिब्रू के लिए समर्थन।

* डेवलपर के अनुकूल: संरचित JSON आउटपुट के लिए मूल समर्थन, फ़ंक्शन कॉलिंग, और दस्तावेज़ वस्तुओं को पचाने में सक्षम।

* गति और दक्षता: AI21 ने Jamba 1.5 मॉडलों के प्रदर्शन को मापा और साझा किया कि मॉडल तुलनीय आकारों के अन्य मॉडलों की तुलना में लंबे संदर्भों पर 2.5 गुना तेज़ अनुमान प्रदर्शित करते हैं।

Jamba 1.5 मॉडल युग्मित दस्तावेज़ विश्लेषण, अनुपालन विश्लेषण और लंबे दस्तावेज़ों के लिए प्रश्न उत्तर जैसे उपयोग के मामलों के लिए एकदम सही हैं। वे कई स्रोतों से जानकारी की आसानी से तुलना कर सकते हैं, जाँच सकते हैं कि क्या अंश विशिष्ट दिशानिर्देशों को पूरा करते हैं, और बहुत लंबे या जटिल दस्तावेज़ों को संभाल सकते हैं।

AI21 Labs का Jamba 1.5 मॉडल परिवार आज अमेरिका पूर्व (N. वर्जीनिया) AWS क्षेत्र में Amazon Bedrock में आम तौर पर उपलब्ध है।

मेरा मानना है कि ये मॉडल भाषा प्रसंस्करण के क्षेत्र में एक महत्वपूर्ण कदम का प्रतिनिधित्व करते हैं। लंबे संदर्भों को संभालने की क्षमता डेवलपर्स और व्यवसायों के लिए नई संभावनाओं की एक विस्तृत श्रृंखला खोलती है। मैं यह देखने के लिए उत्साहित हूँ कि इन मॉडलों का उपयोग करके कौन से अभिनव अनुप्रयोग विकसित किए जाएँगे।